Em 2020, a economia digital representou cerca de 44% do PIB mundial: um total de US$ 32,6 trilhões, alta de 3% em relação ao ano anterior. Este resultado, anunciado durante a Conferência de Economia Digital Global, realizada na China no início de agosto, não deixa dúvida sobre o tamanho – e a importância – dos negócios impulsionados pelas novas tecnologias na economia dos países neste início do século 21.

O que está em marcha é uma irreversível transformação digital das empresas e organizações que passaram a incorporar a internet, dispositivos conectados e inovação tecnológica em seus processos produtivos, na comercialização e na prestação de serviços, criando no mercado e na sociedade novas formas de consumir, viver e trabalhar.

As pessoas estão mais online: trabalham de casa, compram pelos smartphones, deslocam-se por aplicativos e cuidam da saúde via teleatendimento. As companhias estão mais conectadas, realizam negócios digitalmente e usam dados para melhorar o próprio gerenciamento. As cidades estão mais inteligentes, com serviços públicos orientados por informações coletadas por sensores e satélites. E tudo isso faz a economia girar, atraindo a atenção das nações neste momento de renascimento econômico.

De fato, as grandes economias do mundo têm depositado as suas fichas neste movimento rumo aos negócios ancorados em tecnologia. Estados Unidos, China, Alemanha, Reino Unido e Japão são os países que mais investem e aceleram nesta jornada. Na mesma dimensão, agiganta-se a pressão sobre toda a cadeia da indústria e serviços de TI, backbone da transformação digital da economia 4.0. A dependência do processamento de dados para desenvolver produtos, melhorar o atendimento aos clientes e/ou dar mais eficiência à gestão empresarial pressiona as companhias do setor para que ofereçam garantias quanto ao funcionamento adequado de toda essa retaguarda tecnológica. Um contexto de imensa responsabilidade que coloca no centro do debate a importância de se contar com infraestruturas de TI altamente disponíveis, a fim de suportar a imensa demanda de trabalho gerada pela era data centric.

É neste cenário que os principais players de TI têm trabalhado, buscando oferecer ambientes de missão crítica – data centers, arquiteturas de cloud e ecossistemas de edge computing e IoT –, de alto desempenho, segurança e, sobretudo, disponibilidade. São produtos, serviços e protocolos que têm sido desenvolvidos para reduzir os riscos de downtime – a paralisação não programada das operações, ocasionada por quedas de energia, problemas no sistema de refrigeração, mau uso dos equipamentos, falha técnica causada por erro humano, ataques cibernéticos, incêndios, entre outros fatores. Em um mundo hiperconectado, com consumidores e empresas realizando negócios non stop e em tempo real, ficar “fora do ar” não é uma opção mas uma tragédia, muitas vezes difícil de ser revertida.

O custo do downtime

No ano passado, o Uptime Institute apresentou em sua décima pesquisa anual sobre o uso de data centers – com 850 entrevistados entre CIOs, líderes de infraestrutura e operações (I&O), e executivos de TI de todo o mundo – que o downtime gerou prejuízos financeiros superiores a US$ 1 milhão por hora para uma em cada seis empresas consultadas.

Este impacto negativo tende a crescer nos próximos anos, a medida que aumenta a necessidade pelo uso de dados. “Em 2020, tivemos menos eventos graves de downtime no mundo, mas o impacto e o custo deles estão definitivamente crescendo”, declarou o diretor da pesquisa, Andy Lawrence. “Isso acontece mesmo que as interrupções por KW de processamento estejam despencando, graças à crescente dependência do TI por parte das corporações”, completou.

A pesquisa do instituto revelou ainda que:

• 40% das empresas experimentaram um episódio de downtime de proporções significativas nos últimos três anos, com 31% delas confirmando importantes danos monetários e para a reputação;

• 3/4 dos entrevistados admitiram que a responsabilidade pelas paralisações indevidas foi da própria equipe, e que estes eventos eram absolutamente evitáveis caso investimentos em resiliência e treinamento tivessem sido realizados;

• A manutenção preventiva ou mesmo a renovação do hardware está se tornando menos frequente, o que aumenta o risco de interrupções;

• Há um agravamento da falta de mão de obra qualificada para operar os data centers, que se tornaram mais complexos e carecem de profissionais altamente especializados;

Ainda mais impressionantes são os números da pesquisa Hourly Cost of Downtime 2021, realizado pela consultoria norte-americana ITIC. Segundo o estudo, para as grandes companhias globais dos setores financeiro, bancário, de alimentos, energia, comunicações, saúde, varejo, transportes e utilities, o custo do downtime pode variar de US$ 1 milhão a US$ 5 milhões por hora. Um prejuízo que corresponde não apenas aos negócios que deixaram de ser realizados, mas a todas as penalidades previstas contratualmente e exigidas em caso de inoperabilidade dos sistemas.

O relatório indica ainda que 87% das organizações acessadas pelos pesquisadores passaram a requerer em contrato um mínimo de 99,99% de disponibilidade de suas infraestruturas de TI em 2020, denotando “tolerância zero” para o downtime.

Blackout

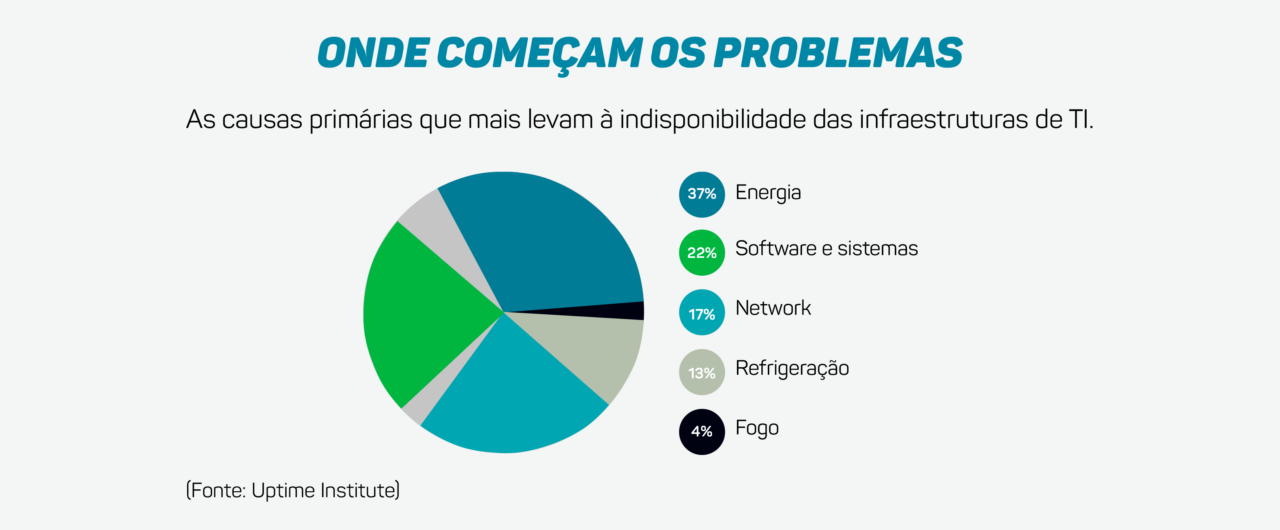

Quedas de energia corresponderam a 37% das causas de downtime das infraestruturas de TI em 2020, conforme monitoramento do Uptime Institute. É o fator principal das interrupções, sobretudo a partir de falhas na fonte de alimentação (UPS) e nos switches e geradores.

Portanto, cuidar da estabilidade do fornecimento de energia é essencial para os operadores e empresas de TI. Em especial, quando estes equipamentos e sites estão localizados em zonas sensíveis a eventos climáticos.

Tempestades elétricas, tornados, furacões e demais eventos naturais de grande porte, comuns em regiões tropicais, por exemplo, podem causar a interrupção de sistemas que resultem no downtime. Neste sentido, contar com serviços de monitoramento climático dedicado a antecipar os eventos é a tática mais adequada.

O perigo que vem do fogo

Outro fator de alto risco são os incêndios em data centers. Embora raros, eles acontecem, conforme revela o levantamento recente feito pelo DCIRN – Data Center Incident Reporting Networking. Entre 2003 e 2021 foram registrados 31 incêndios em centros de dados ao redor do mundo. O mais recente deles aconteceu em Strasbourg, na França, em março deste ano, quando as chamas consumiram dois data centers inteiros do complexo OVHCloud, o maior provedor de nuvem da Europa. O episódio deixou fora do ar milhões de sites e aplicações, incluindo plataformas digitais dos governos da Polônia, Reino Unido e da própria França.

Leia mais: Como evitar os danos gerados pelo incidente no maior provedor de nuvem da Europa?

Excluindo o caso francês, o relatório do DCIRN calculou que o tempo médio de indisponibilidade dos data centers afetados pelos incêndios foi de 17,5 horas. A partir desta estimativa e somado os custos do downtime comentados anteriormente, é possível se compreender a dimensão do prejuízo financeiro e de reputação que estes eventos causaram não apenas aos operadores dos centros de processamento, mas a todos os seus clientes.

Outro dado curioso do estudo: 73% dos incêndios tiveram início pela manhã, entre 9h e 11h. A constatação derruba o senso comum de que incidentes deste tipo ocorreriam, em sua maioria, fora do horário de expediente. E reforça também o indício apurado na pesquisa do Uptime Institute indicando que as interrupções nas operações têm origem em possíveis falhas cometidas pelas equipes.

O fator humano

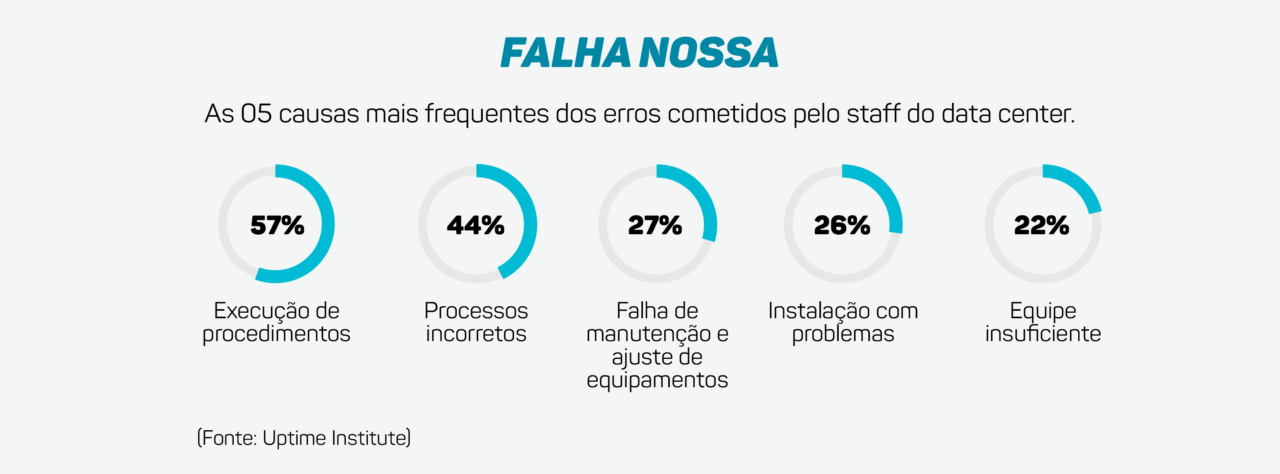

Ainda na pesquisa sobre outages em data centers do Uptime Institute, o índice das interrupções geradas por ações equivocadas das equipes de trabalho tem aumentado. Para 75% dos entrevistados no relatório, a indisponibilidade das operações registrada no último ano poderia ter sido evitada com uma melhor gestão ou aplicação correta dos processos – em outras palavras, se a atuação humana fosse mais adequada.

As razões mais comuns que levariam os profissionais ao erro, conforme o relatório, estão demonstradas na tabela a seguir:

Dado o elevado e crescente custo da indisponibilidade, o instituto sugere investimentos emergenciais na capacitação dos profissionais e reforço do staff responsável por operar a infraestrutura, a fim de mitigar o risco de downtime e os seus volumosos prejuízos para o caixa das companhias.

Como garantir a alta disponibilidade

A análise de todo este contexto oferece um rico material para orientar a atuação das empresas do setor na busca pela alta disponibilidade das infraestruturas de TI. A complexidade do cenário exige um conjunto de ações coordenadas e integradas para que a estratégia possa ser bem-sucedida. O foco deve se concentrar em tornar as infraestruturas mais resilientes e seguras, contar com profissionais altamente especializados e serviços que promovam maior eficiência na gestão dos ambientes.

Dentre os passos principais desta jornada, podemos destacar:

- Obtenção de certificações – Para o setor, as certificações são a garantia comprovada de que os altos padrões de qualidade operacional, desempenho e segurança foram devidamente aplicados à infraestrutura. Elas demonstram a capacidade do data center em contribuir com a performance e a disponibilidade desejada pelo cliente. A certificação mais conhecida é a TIER, desenvolvida pelo Uptime Institute. Ela se divide em quatro categorias distintas, que definem cada etapa do projeto, conforme demonstrado a seguir:

Tier I: Classificação Básica

• Ideal para pequenos negócios e onde a TI esteja focada nos processos internos;

• 99,671% de uptime (tempo de atividade);

• Não há exigência de redundância;

• 29 horas de inatividade por ano.

• Prevê espaço dedicado para os equipamentos de TI, UPS, gerador e refrigeração.

Tier II: Data Center Redundante

• Voltado para negócios cuja criticidade é maior, podendo não suportar indisponibilidades durante horário comercial;

• 99,749% de uptime;

• 22 horas de inatividade por ano;

• Redundância parcial em energia e climatização.

Tier III: Manutenção Concorrente

• Ideal para empresas que oferecem suporte 24×7, com recursos de TI que suportam processos de negócios automatizados;

• 99.982% de uptime;

• 1,6 hora de inatividade por ano;

• Redundância total em energia e climatização, não tolera interrupção de qualquer ordem, mesmo para manutenção ou troca de equipamentos.

Tier IV: Alta Tolerância a Falhas

• Foco nos negócios com exigência de disponibilidade do TI em qualquer cenário de incidentes técnicos e sem parada dos servidores;

• 99,995% de uptime;

• Redundância integral;

• Qualquer que seja o motivo da interrupção, a operação não é afetada;

• Sistema completamente automatizado, com redução do risco de falha humana.

Soluções modulares de TI como Salas-Cofre, salas seguras e racks Edge, necessitam de nível TIER adequado para garantir a disponibilidade requerida dos servidores. Com relação a segurança física, outras certificações são requeridas como a NBR 15247 e EN 1047-2. Estas estruturas precisam atestar a sua capacidade de proteção física dos equipamentos no seu interior e, principalmente, das informações ali contidas diante de riscos variados – de incêndios a enchentes, acessos indevidos e sabotagens.

- Contratação de equipes especializadas – Contar com profissionais capacitados para operar infraestruturas de TI cada vez mais complexas é essencial para a redução do risco de downtime. Isso pode ser alcançado de duas formas: na contratação direta do funcionário para atuar na área interna de TI da companhia; ou na terceirização do time de trabalho, a partir de empresas reconhecidas no mercado que possam assumir o controle do ambiente crítico de forma segura e assertiva, com profissionais apoiados por Centros de Excelência que cuidarão das atualizações e reciclagens do conhecimento técnico. Neste segundo modelo, há outras duas vantagens embutidas: a diminuição dos custos com a equipe e a liberação dos profissionais já existentes para que se concentrem exclusivamente no desenvolvimento de novos negócios, não mais com a operação do TI.

- Adoção de serviços continuados – Esta é uma solução 360º para o gerenciamento físico e lógico do ambiente de missão crítica. Envolve serviços de manutenção nas fases preventiva, preditiva, evolutiva e corretiva do data center, para garantir a continuidade das operações; o monitoramento Online e em tempo real de toda a infraestrutura; a gestão operacional do ambiente (servidores, storage e network) – On IT Management –, seja na camada lógica ou break & fix; e um programa Life Extended, que visa prolongar a vida útil de peças, componentes e equipamentos mesmo após o fim da garantia fornecida pelos fabricantes, reduzindo custos com atualizações das máquinas e otimizando a performance.

Soma-se a este último passo a necessidade de capilaridade das equipes, que precisam abranger a maior parte do território nacional a fim de prestar todos os atendimentos em tempo hábil e de forma eficiente. Bem como um robusto estoque de peças sobressalentes, que seja acessível a todos os clientes.

Investir em alta disponibilidade, portanto, é condição sine qua non para empresas e operadores de infraestruturas de TI. É por meio dessa jornada que poderá ser oferecida a retaguarda fundamental para o desenvolvimento da economia digital e de toda a sociedade do futuro.

A tecnologia tem um papel crucial neste processo: na criação de novos modelos de negócio; para que as cidades se tornem mais inteligentes; na oferta de mais qualidade de vida para as pessoas; para o desenvolvimento de um modo mais sustentável de viver, trabalhar e ganhar dinheiro; e para a preservação do meio ambiente. Por trás de tudo isso está a indústria de TI, resiliente e disponível, que precisa ser capaz de apoiar e acelerar a transformação para um mundo melhor.