En una sociedad y una economía cada vez más centradas en los datos, donde el Big Data ejerce un poder gravitacional sobre las aplicaciones, los servicios, el software, los modelos de negocio y los consumidores, a partir de esta década será esencial una solución: el computación periférica.

La estrategia que lleva al procesamiento de datos cerca de la fuente generadora responde a una exigencia innegociable de velocidad en tiempos de nuevas tecnologías como el 5G y el IoT (Internet de las cosas). Estas innovaciones tienden a acercar las aplicaciones y los servicios al origen de los datos por la necesidad de baja latencia y de alta velocidad de transferencia de datos.

Pero, ¿por qué la velocidad de respuesta se ha convertido en un factor crucial en este momento para la industria de TI?

Desde los primeros mainframes de la década de 1970, se ha producido un cambio en la escala de relevancia de lo que hace que el procesamiento de datos sea más eficiente. Al principio, se apostaba por el potencial de los equipos. Después, la capacidad de transmisión se convirtió en algo vital. Ahora, es la conectividad la que define el éxito de la solución.

Por lo tanto, tanto el Internet de las cosas como la nueva banda de telefonía —y todo el universo de aplicaciones y soluciones derivadas de ambos— solo serán plenamente efectivos si pueden contar con redes conectadas de manera eficiente, que dispongan de altas tasas de transferencia de datos y respuestas en el menor tiempo posible.

En este diálogo entre máquinas, las estrategias de procesamiento centralizadas en la nube, por ejemplo, no pueden garantizar la menor latencia, ya sea debido a posibles debilidades de la infraestructura de conectividad o incluso a fluctuaciones en la red de transmisión.

El edge computing surge, entonces, como un facilitador de alta velocidad actualmente requerida, al llevar el procesamiento al borde, lo que acorta la distancia dato-procesamiento-respuesta y evita los inconvenientes de la falta de conectividad.

`MÁS INFORMACIÓN`: Escucha en nuestro podcast greenTALKS el episodio sobre “Los retos de la conectividad digital”. [Haz clic aquí.](https://spoti.fi/34pH7Pb)

Parpadear

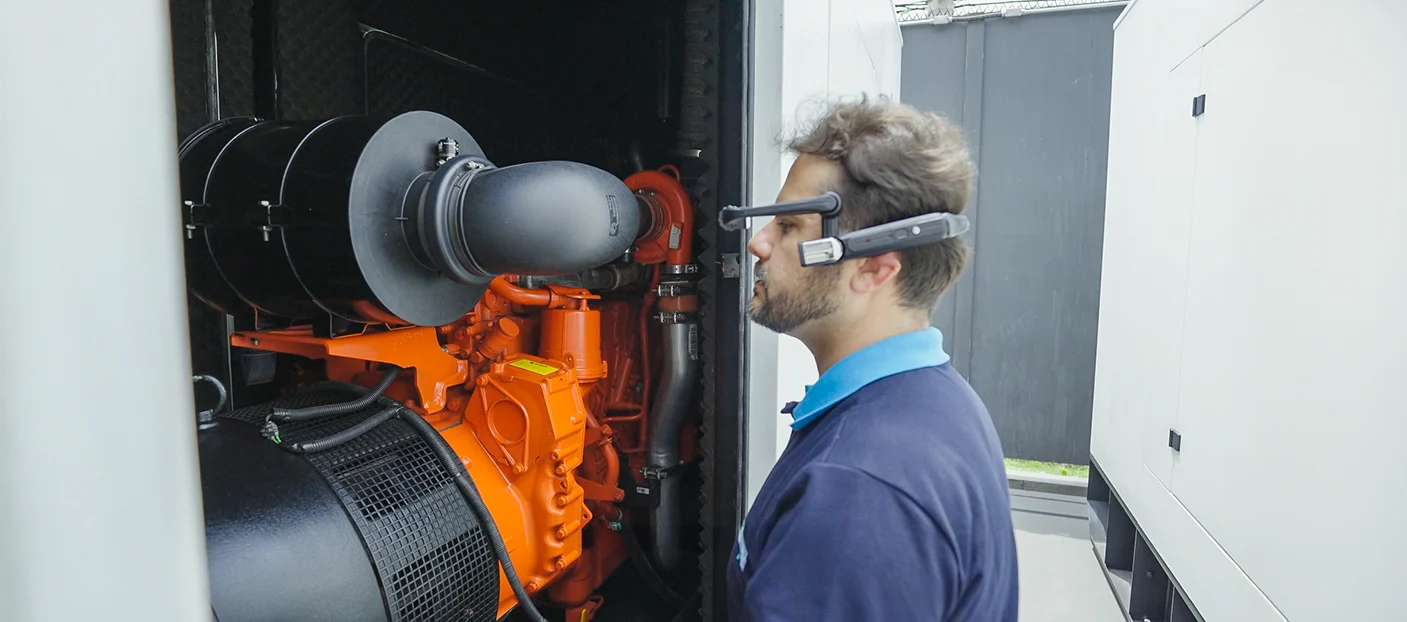

En la práctica, la aplicación de la computación periférica tendrá un impacto en varios sectores de la economía que ya necesitan esta agilidad para desarrollarse. La telemedicina es uno de ellos.

Tras el auge de las consultas por videoconferencia en 2020, provocado por el aislamiento social derivado de la pandemia de COVID-19, el siguiente paso es la consolidación segura de las cirugías a distancia. Debido a su complejidad natural, el procedimiento exige un tiempo mínimo de respuesta entre la conciencia situacional sobre el paciente y la decisión del médico, que, por regla general, se encuentra lejos del quirófano. En este caso, el tiempo transcurrido entre la obtención de los datos clínicos mediante sensores y su transmisión al cirujano puede marcar la diferencia entre la vida y la muerte.

Un ejemplo similar se da en el sector automovilístico, cuya disrupción se está sintiendo con fuerza en este momento de transformación digital.

Con el aumento del interés por la movilidad autónoma, donde los vehículos sin conductor Para comunicarse directamente con los dispositivos de gestión del tráfico situados en las vías públicas, los fabricantes de automóviles y las empresas tecnológicas invierten mucho en el desarrollo de equipos que certifiquen este intercambio de información en milésimas de segundo. Al fin y al cabo, basta un abrir y cerrar de ojos para determinar, o no, la ocurrencia de un accidente de tráfico, ya sea el conductor humano o digital.

Este diálogo entre infraestructuras y dispositivos periféricos, por cierto, no solo es la clave para el éxito de la estrategia, sino también una valiosa oportunidad de negocio. Según el informe The State of the Edge 2020, de la Fundación Linux, las inversiones en CAPEX previstas para esta década superarán los US$ 700 mil millones, centrado en las infraestructuras de computación periférica.

Menos Energía

Además de la cuestión de la latencia, la computación periférica ayuda a mitigar otro efecto de la estrategia de procesamiento centralizada: el costo energético.

Se estima que las grandes infraestructuras de centros de datos y nubes consumen anualmente alrededor de 11 TP3T de la energía eléctrica producida en el mundo, es decir, unos 190 TWh, según un estudio realizado en 2020 por la AIE (Agencia Internacional de la Energía).

En una red de centros de datos periféricos, el consumo se reduce de MWh a KWh. Esto se debe a su ubicación, que evita las largas líneas de transmisión, y a la capacidad de procesar y almacenar los datos cerca de la fuente generadora.

Un ejemplo práctico de esta ventaja se puede ver en el agroindustria. Si el procesamiento de datos centralizado y remoto encarece la instalación de sensores en una propiedad – para supervisar las condiciones del suelo y gestionar los recursos hídricos –, con la infraestructura periférica esta dificultad se diluye precisamente por la independencia de la red para realizar las tareas. Sin los costos de transmisión, la solución se vuelve más económica, sostenible y rentable.

Ciudades inteligentes “periféricas”

Las ciudades inteligentes son otras beneficiarias de la computación periférica. Su aplicación contribuye a la implementación de soluciones digitales relacionadas con la movilidad urbana, la seguridad pública y áreas como la salud.

Es fundamental para hacer realidad el diálogo entre vehículos, edificios y el sistema vial, por ejemplo. En materia de seguridad, aporta mayor agilidad en el tratamiento de las imágenes captadas por las cámaras de vigilancia.

Además, la computación en el borde se puede instalar en un sistema de alertas contra accidentes naturales causados por catástrofes climáticas. Las inundaciones, los tornados e incluso los tsunamis pueden ver reducidos sus devastadores impactos mediante el uso de una red de procesamiento de datos cercana a los sensores capaz de activar alarmas y bloquear inmediatamente las zonas de riesgo, entre otras medidas preventivas que permiten salvar vidas.

LEER MÁS: “La tecnología en la gestión de riesgos de eventos climáticos“.

Todo es cuestión de tiempo de respuesta y, en este proceso de búsqueda de la menor latencia, el computación periférica tiene un papel determinante para satisfacer las aspiraciones de un Un mundo más conectado, con máquinas más rápidas y demandas más urgentes..