En 2020, la economía digital representaba alrededor del 44% del PIB mundial: un total de 32,6 billones de dólares, un 3% más interanual. Este resultado, anunciado durante la Conferencia Mundial sobre Economía Digital, celebrada en China a principios de agosto, no deja lugar a dudas sobre el tamaño – y la importancia – de las empresas impulsadas por las nuevas tecnologías en las economías de los países a principios del siglo XXI.

Lo que está en marcha es una transformación digital irreversible de empresas y organizaciones que han empezado a incorporar internet, los dispositivos conectados y la innovación tecnológica en sus procesos de producción, comercialización y prestación de servicios, creando nuevas formas de consumir, vivir y trabajar en el mercado y en la sociedad.

La gente está más en línea: trabaja desde casa, compra a través de teléfonos inteligentes, viaja mediante aplicaciones y cuida de su salud a través de la teleasistencia. Las empresas están más conectadas, realizan sus negocios digitalmente y utilizan los datos para mejorar su gestión. Las ciudades son más inteligentes, con servicios públicos guiados por la información recogida por sensores y satélites. Y todo esto hace girar la economía, atrayendo la atención de las naciones en este momento de renacimiento económico.

De hecho, las principales economías del mundo han puesto sus fichas en este movimiento hacia empresas ancladas en la tecnología. Estados Unidos, China, Alemania, Reino Unido y Japón son los países que más invierten y aceleran este camino.

En la misma dimensión, se agrava la presión sobre toda la cadena industrial y los servicios informáticos, backbone de la transformación digital de la economía 4.0. La dependencia del tratamiento de datos para desarrollar productos, mejorar el servicio al cliente y/o hacer más eficiente la gestión empresarial presiona a las empresas del sector para que ofrezcan garantías sobre el buen funcionamiento de todo este respaldo tecnológico.

Un contexto de inmensa responsabilidad que sitúa en el centro del debate la importancia de disponer de una infraestructura informática de alta disponibilidad para soportar la inmensa demanda de trabajo generada por la era data-centric.

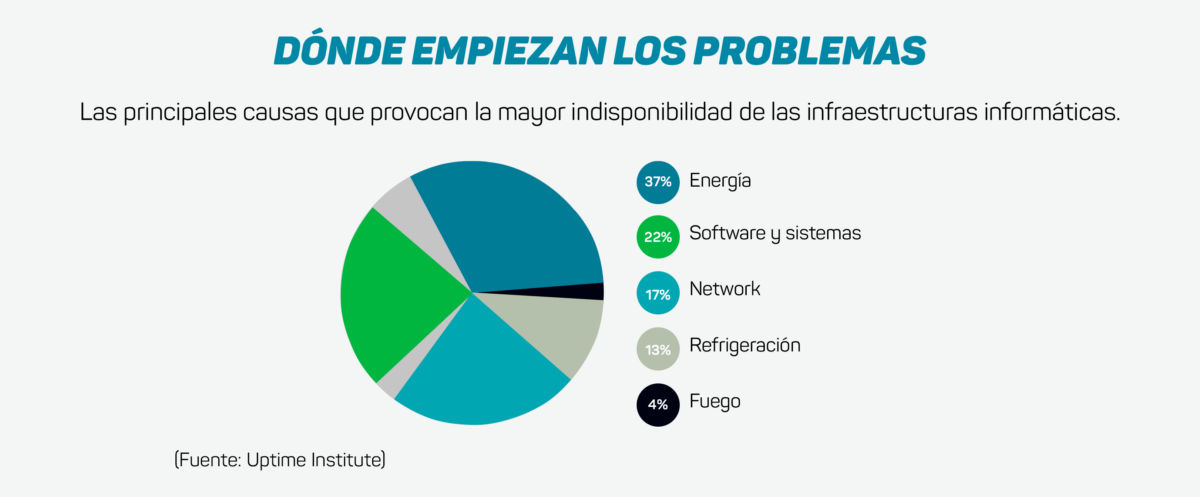

Es en este escenario en el que vienen trabajando los principales actores de TI, que buscan ofrecer entornos de misión crítica -centros de datos, arquitecturas cloud y ecosistemas de edge computing e IoT- de alto rendimiento, seguridad y, sobre todo, disponibilidad. Se trata de productos, servicios y protocolos que se han desarrollado para reducir los riesgos de tiempo de inactividad: la interrupción no programada de las operaciones causada por cortes de energía, problemas en el sistema de refrigeración, uso indebido de los equipos, fallos técnicos causados por errores humanos, ciberataques, incendios, entre otros factores. En un mundo hiperconectado, con consumidores y empresas haciendo negocios sin parar y en tiempo real, estar «desconectado» no es una opción, sino una tragedia, a menudo difícil de revertir.

El coste del downtime

El año pasado, el Uptime Institute informó en su décima encuesta anual sobre el uso de los centros de datos – con 850 encuestados entre directores de sistemas de información, responsables de infraestructuras y operaciones (I&O) y ejecutivos de TI de todo el mundo – de que el tiempo de inactividad generaba pérdidas económicas de más de un millón de dólares por hora para una de cada seis empresas consultadas.

Es probable que este impacto negativo crezca en los próximos años a medida que aumente la necesidad de uso de datos. «En 2020, tuvimos menos incidentes graves de inactividad en el mundo, pero su impacto y coste están creciendo definitivamente», dijo el director de la encuesta, Andy Lawrence. «Esto sucede a pesar de que las interrupciones por KW de procesamiento están cayendo en picado, gracias a la creciente dependencia de las TI por parte de las empresas», añadió.

La encuesta del instituto reveló además que:

- El 40% de las empresas ha sufrido un episodio de downtime de proporciones significativas en los últimos tres años, y el 31% de ellas ha confirmado importantes daños monetarios y de reputación;

- Tres cuartas partes de los encuestados admitieron que la responsabilidad de los tiempos de inactividad indebidos recaía en el propio personal, y que estos sucesos eran absolutamente evitables si se hubiera invertido en resiliencia y formación;

- El mantenimiento preventivo o incluso la renovación del hardware son cada vez menos frecuentes, lo que aumenta el riesgo de interrupciones;

- Se agrava la falta de mano de obra cualificada para explotar los centros de datos, que se han vuelto más complejos y carecen de profesionales altamente especializados;

Aún más impresionantes son las cifras de la encuesta Hourly Cost of Downtime 2021, realizada por la consultora estadounidense ITIC. Según el estudio, para las grandes empresas mundiales de los sectores financiero, bancario, alimentario, energético, de comunicaciones, sanitario, minorista, de transporte y de servicios públicos, el coste del tiempo de downtime puede oscilar entre 1 y 5 millones de dólares por hora. Una pérdida que corresponde no sólo al negocio que se deja de realizar, sino a todas las penalizaciones previstas contractualmente y exigidas en caso de inoperatividad de los sistemas.

El informe también indica que el 87% de las organizaciones a las que accedieron los investigadores empezaron a exigir por contrato una disponibilidad mínima del 99,99% de su infraestructura informática en 2020, lo que denota «tolerancia cero» con el tiempo de downtime.

Blackout

Los cortes de electricidad representaron el 37% de las causas de inactividad de la infraestructura de TI en 2020, según el seguimiento realizado por el Uptime Institute. Es el principal factor de cortes, sobre todo por fallos en el suministro eléctrico (SAI) y en los interruptores y generadores.

Por eso, cuidar la estabilidad del suministro eléctrico es esencial para los operadores y empresas de TI. Sobre todo cuando estos equipos y emplazamientos están situados en zonas sensibles a los fenómenos meteorológicos.

Tormentas eléctricas, tornados, huracanes y otros grandes fenómenos naturales, habituales en las regiones tropicales, por ejemplo, pueden provocar la interrupción de los sistemas, con el consiguiente tiempo de downtime. En este sentido, apoyarse en servicios especializados de vigilancia del clima para anticiparse a los acontecimientos es la táctica más adecuada.

El peligro del fuego

Otro factor de alto riesgo son los incendios en los centros de datos. Aunque raros, ocurren, como revela una encuesta reciente de DCIRN (Data Center Incident Reporting Networking). Entre 2003 y 2021 se registraron 31 incendios en centros de datos de todo el mundo. La más reciente ocurrió en Estrasburgo (Francia) en marzo de este año, cuando las llamas consumieron dos centros de datos enteros del complejo OVHCloud, el mayor proveedor de nubes de Europa. El episodio dejó fuera de servicio millones de sitios web y aplicaciones, incluidas plataformas digitales de los gobiernos de Polonia, Reino Unido y la propia Francia.

Más información: ¿Cómo evitar los daños de un incidente en el mayor proveedor de nube de Europa?

Excluyendo el caso francés, el informe del DCIRN estimaba que el tiempo medio de inactividad de los centros de datos afectados por los incendios fue de 17,5 horas. A partir de esta estimación y sumado a los costes de inactividad comentados anteriormente, es posible comprender la magnitud del perjuicio financiero y de reputación que estos sucesos causaron no sólo a los operadores de los centros de procesamiento, sino a todos sus clientes.

Otro dato curioso del estudio: el 73% de los incendios se iniciaron por la mañana, entre las 9 y las 11 horas. El hallazgo anula el sentido común de que los incidentes de este tipo se producirían sobre todo fuera de las horas de trabajo. Y también refuerza las pruebas encontradas en la investigación del Uptime Institute, que indican que las interrupciones de las operaciones se deben a posibles fallos cometidos por los equipos.

El factor humano

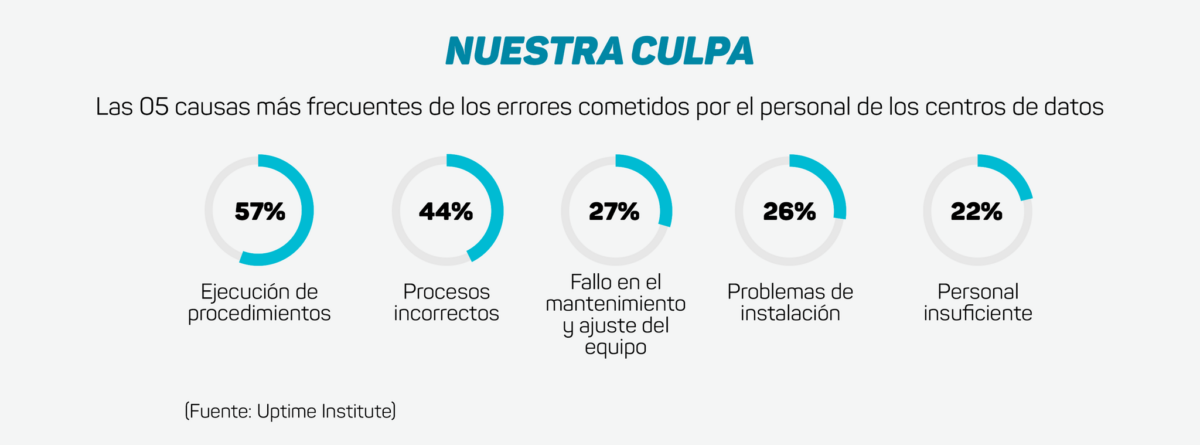

También en la encuesta del Uptime Institute sobre interrupciones en centros de datos ha aumentado el índice de interrupciones generadas por acciones erróneas de los equipos de trabajo. Para el 75% de los encuestados en el informe, la indisponibilidad de operaciones registrada en el último año podría haberse evitado con una mejor gestión o una correcta aplicación de los procesos, es decir, si la actuación humana hubiera sido más adecuada.

Las razones más comunes que llevarían a los profesionales a equivocarse, según el informe, se muestran en la siguiente tabla:

Ante el elevado y creciente coste de la indisponibilidad, el instituto sugiere inversiones de emergencia en la formación de profesionales y refuerzo del personal responsable de la explotación de la infraestructura, con el fin de mitigar el riesgo de downtime y sus voluminosas pérdidas para la tesorería de las empresas.

Cómo garantizar una alta disponibilidade

El análisis de todo este contexto ofrece un rico material para orientar la actuación de las empresas del sector en la búsqueda de una alta disponibilidad de las infraestructuras informáticas. La complejidad del escenario requiere un conjunto de acciones coordinadas e integradas para que la estrategia tenga éxito. Hay que centrarse en hacer las infraestructuras más resistentes y seguras, contando con profesionales altamente especializados y servicios que promuevan una mayor eficiencia en la gestión de los entornos.

Entre las principales etapas de este viaje, podemos destacar:

1. Conseguir certificaciones – Para el sector, las certificaciones son una garantía demostrada de que los altos estándares de calidad operativa, rendimiento y seguridad se han aplicado correctamente a la infraestructura. Demuestran la capacidad del centro de datos para contribuir al rendimiento y la disponibilidad deseados por el cliente. La certificación más conocida es TIER, desarrollada por el Uptime Institute. Se divide en cuatro categorías distintas que definen cada etapa del proyecto, como se muestra a continuación:

Tier I: Clasificación básica

- Ideal para pequeñas empresas y donde la TI se centra en los procesos internos;

- 99,671% de tiempo de actividad;

- No se exige redundancia;

- 29 horas de inactividad al año;

- Ofrece espacio exclusivo para equipos informáticos, SAI, generador y refrigeración.

Tier II: Data Center Redundante

- Dirigido a empresas cuya criticidad es mayor, y que pueden no soportar la indisponibilidad durante el horario laboral;

- 99,749% de uptime;

- 22 horas de inactividad al año;

- Redundancia parcial en energía y aire acondicionado.

Tier III: Mantenimiento Simultáneo

- Ideal para empresas que ofrecen asistencia 24×7, con recursos informáticos que dan soporte a procesos empresariales automatizados;

- 99.982% de uptime;

- 1,6 horas de inactividad al año;

- Redundancia total en energía y climatización, no tolera interrupciones de ningún tipo, ni siquiera por mantenimiento o sustitución de equipos.

Tier IV: Alta tolerancia a Fallos

- Céntrese en el negocio con el requisito de disponibilidad de TI en cualquier escenario de incidencias técnicas y sin parar los servidores;

- 99,995% de uptime;

- Redundancia integral;

- Sea cual sea el motivo de la interrupción, la operación no se ve afectada;

- Sistema totalmente automatizado, con menor riesgo de error humano.

Las soluciones informáticas modulares, como las cámaras acorazadas, las salas seguras y los bastidores Edge, necesitan el nivel TIER adecuado para garantizar la disponibilidad requerida de los servidores. En cuanto a la seguridad física, se exigen otras certificaciones, como la NBR 15247 y la EN 1047-2. Estas estructuras deben certificar su capacidad de protección física de los equipos en su interior y, principalmente, de la información contenida en ellos frente a diversos riesgos, desde incendios a inundaciones, accesos indebidos y sabotajes.

2. Contratación de equipos especializados – Contar con profesionales capacitados para manejar infraestructuras informáticas cada vez más complejas es esencial para reducir el riesgo de tiempos de downtime. Esto se puede lograr de dos maneras: contratando directamente al empleado para que trabaje en el área interna de TI de la empresa; o tercerizando el equipo de trabajo, de empresas reconocidas en el mercado que puedan tomar el control del ambiente crítico de manera segura y asertiva, con profesionales apoyados por Centros de Excelencia que se encargarán de la actualización y reciclaje de conocimientos técnicos. En este segundo modelo, hay otras dos ventajas incorporadas: la reducción de costes con el equipo y la liberación de los profesionales existentes para centrarse exclusivamente en el desarrollo de nuevos negocios, ya no con la operación de TI.

3. Adopción de servicios continuos – Se trata de una solución de 360º para la gestión física y lógica del entorno de misiones críticas. Implica servicios de mantenimiento en las fases preventiva, predictiva, evolutiva y correctiva del centro de datos, para garantizar la continuidad de las operaciones; la monitorización en línea y en tiempo real de toda la infraestructura; la gestión operativa del entorno (servidores, almacenamiento y red) – ON IT Management –, ya sea en la capa lógica o break & fix; y un programa Life Extended, cuyo objetivo es prolongar la vida útil de piezas, componentes y equipos incluso después del final de la garantía proporcionada por los fabricantes, reduciendo costes con actualizaciones de máquinas y optimizando el rendimiento.

A este último paso se añade la necesidad de capilaridad de los equipos, que deben cubrir la mayor parte del territorio nacional para prestar todos los servicios a tiempo y con eficacia. Así como un sólido stock de piezas de repuesto, accesible a todos los clientes.

Invertir en alta disponibilidad, por tanto, es una condición sine qua non para las empresas y los operadores de infraestructuras informáticas. Es a través de este viaje como se puede proporcionar la columna vertebral fundamental para el desarrollo de la economía digital y de toda la sociedad del futuro.

La tecnología desempeña un papel crucial en este proceso: en la creación de nuevos modelos de negocio; en hacer las ciudades más inteligentes; en proporcionar una mayor calidad de vida a las personas; en desarrollar una forma más sostenible de vivir, trabajar y ganar dinero; y en preservar el medio ambiente. Detrás de todo esto hay una industria de TI resistente y disponible que debe ser capaz de apoyar y acelerar la transformación hacia un mundo mejor.